-

在家就能训练 700 亿大模型!Answer.AI 开源项目冲上 HN 热榜

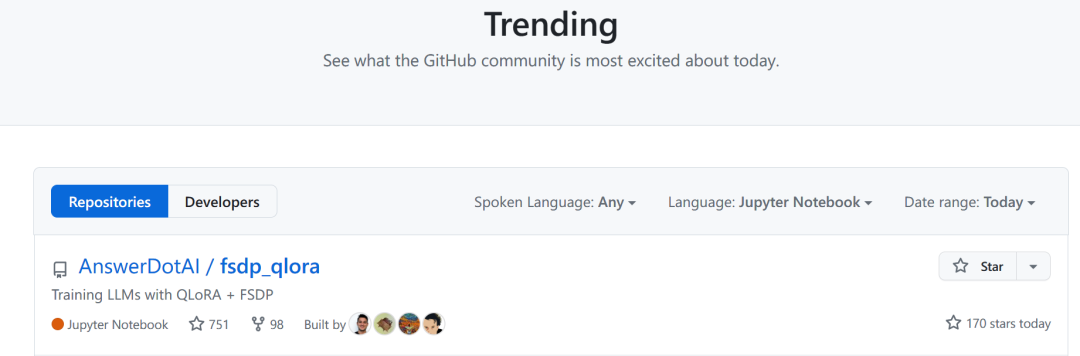

整理 | 王启隆 出品 | AI 科技大本营(ID:rgznai100) 自从 Meta 入局开源了 LLaMA,大模型圈的创业浪潮似乎就没停下来过,数以万计的初创公司崭露头角,颇有当年个人计算机(PC)行业在 Linux 系统开源化之后的繁荣景象。 就在去年 12 月,曾经创立了 fast.ai 的 Jeremy Howard 和 Eric Ries 创建了一个名为 Answer.AI 的新人工智能研发实验室。该实验室得到了 Decibel VC 的 1000 万美元资金支持,旨在通过专注于利用现有技术创建实用的人工智能应用程序。 Jeremy Howard 准确地说,Answer.AI 对自己的定位是「独特的营利性质研发实 验室」,其精神更接近 19 世纪的「电力实验室」,和当前如火如荼的 AI 初创浪潮区分开来。 3 月 6 日,Answer.AI 终于在自己的官网博客上正式公开了自己的第一个项目:一个完全开源的系统,首次能够高效地在配备两个或多个标准游戏显卡(如老黄家的 RTX 3090 或 4090)的普通台式电脑上训练一个 70b(700 亿参数)的大规模语言模型。目前,Hacker News 对该项目已经讨论得热火朝天。 在 GitHub Trending 上,这一项目今天也冲上了 Jupyter Notebook 的热度第一。 “端侧大模型”是今年相当热门的话题,之前开源了 7b 模型的法国公司 Mistral 就用一个小模型击败了 LLaMA,还得到了微软的青睐;而 公众 号曾分享过的 1 bit 大模型更是从底层掀翻了大模型牌局。Answer.AI 的这个项目基于 FSDP 和 QLoRA 技术,是 Answer.AI、Tim Dettmers、以及 Hugging Face 团队的 Titus von Koeller 和 Sourab Mangrulkar 共同合作的成果。 接下来,让我们一起来看看 A nswer.AI 究竟用了哪些手段实现“在家训练大模型”,一同展望「人人都能创建个性化模型」的时刻还有多久到来。 原文链接:https://www.answer.ai/posts/2024-03-06-fsdp-qlora.html#a-first-step 用游戏显卡训练大模型! 2024 年的今天,训练深度学习模型使用的硬件通常分为两大阵营。 一派是数据中心级别的高端硬件,比如 H100s 和 A100s,售价高达数十万美元;另一派则是配备有游戏显卡的普通台式电脑,例如一对 RTX 4090 显卡,总价不足 1 万美元(甚至可以采用二手部件拼装,俗称「捡垃圾」,成本不到预装整机的一半)。 关键在于,尽管游戏显卡的价格仅为数据中心级显卡的十分之一,但它们的性能却相当接近。设想若能有效利用这类成本低廉的游戏显卡训练大语言模型,无疑将是一个巨大的进步。 然而,现实情况是, 顶级的数据中心级显卡拥有 80 GB 的…